Amnistía Internacional ha señalado que el Parlamento Europeo debe utilizar una votación plenaria que consolide su posición final sobre la Ley de Inteligencia Artificial de la Unión Europea (Ley AI) «para prohibir los sistemas de elaboración de perfiles racistas y discriminatorios dirigidos a migrantes y otros grupos marginados».

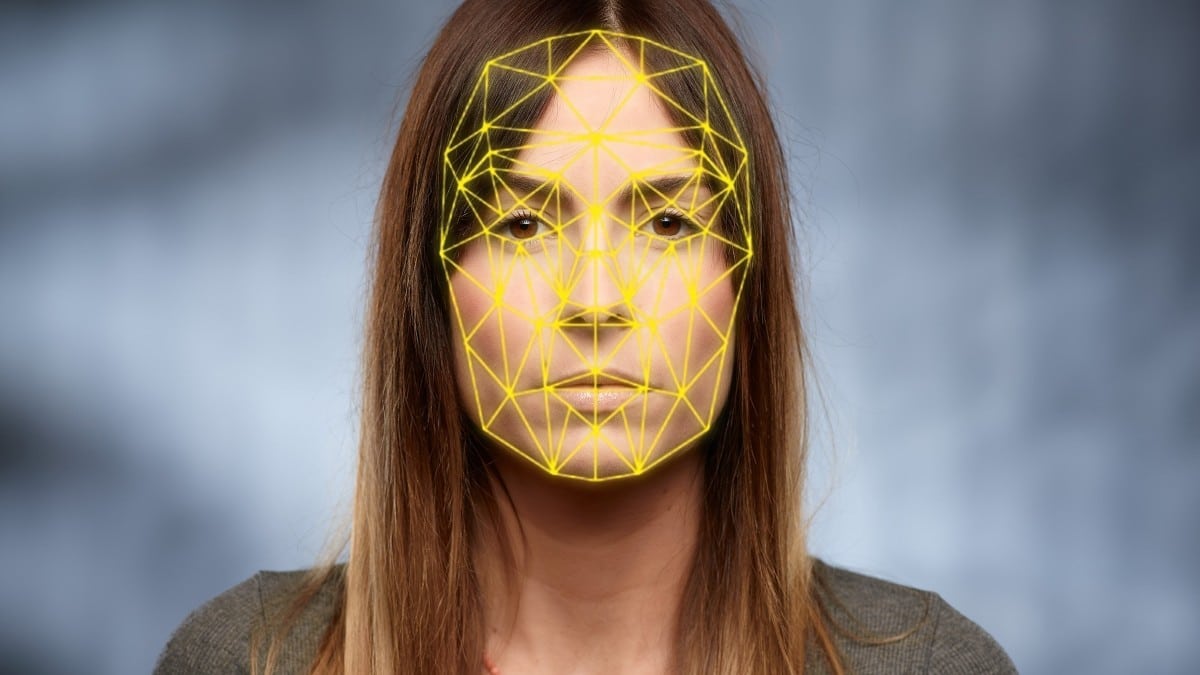

La organización pide al Parlamento Europeo que prohíba el uso de tecnologías de vigilancia masiva, como las herramientas de identificación biométrica retrospectiva y remota en vivo, en la Ley de IA, una legislación que califica como «histórica».

La investigación de Amnistía Internacional muestra que la tecnología invasiva de reconocimiento facial «amplifica la aplicación de la ley racista y discriminatoria contra las personas racializadas, incluidas las prácticas de detención y registro que afectan de manera desproporcionada a las personas negras y latinas». También cree que «se utiliza para prevenir y restringir el movimiento de migrantes y solicitantes de asilo».

«Existe el riesgo de que el Parlamento Europeo pueda anular considerables protecciones de los derechos humanos alcanzadas durante la votación del comité el 11 de mayo, abriendo la puerta al uso de tecnologías que están en conflicto directo con el derecho internacional de los derechos humanos», dice Mher Hakobyan, asesor de defensa de Regulación de la IA en Amnistía Internacional.

Para la organización, los estados miembros de la Unión Europea, «en su intento por fortalecer los muros de la ‘Fortaleza Europa’, han recurrido cada vez más al uso de tecnologías opacas y hostiles para facilitar el abuso contra migrantes, refugiados y solicitantes de asilo en sus fronteras».

«Con un entorno tan persistentemente inhóspito hacia las personas que huyen de guerras y conflictos o que buscan una vida mejor, es vital que el Parlamento Europeo no desestime los daños de los sistemas racistas de IA. Los legisladores deben prohibir la elaboración de perfiles racistas y los sistemas de evaluación de riesgos, que etiquetan a los migrantes y solicitantes de asilo como ‘amenazas’; y tecnologías de pronóstico para predecir los movimientos fronterizos y negar a las personas el derecho de asilo», sentencia Mher Hakobyan.

Aunque la Ley de IA puede ayudar a «prevenir y reducir» los daños causados por las nuevas tecnologías en Europa, Amnistía Internacional avisa de que «es fundamental que la UE no contribuya a las violaciones de los derechos humanos mediante la exportación de tecnologías draconianas más allá de sus territorios».

Prohibir el reconocimiento facial

Por ello, apunta que la Ley de IA «debe prohibir la exportación de cualquier sistema cuyo uso no esté permitido en la UE, como el reconocimiento facial y otras tecnologías de vigilancia«.

«El Parlamento Europeo tiene el deber de defender los derechos humanos. Cualquier cosa que no sea una prohibición total de las tecnologías utilizadas para la vigilancia masiva, la vigilancia policial racista y la elaboración de perfiles sería un incumplimiento de ese deber», apunta Mher Hakobyan, destacando que los legisladores de la UE también «deben asegurarse de que las tecnologías prohibidas dentro de la UE no se exporten para cometer abusos contra los derechos humanos en otros lugares»: «Esta legislación debe proteger y promover los derechos humanos de todas las personas, no solo de las personas en Europa».

La Comisión Europea propuso una legislación que rige el uso de la Inteligencia Artificial el 21 de abril de 2021. El Consejo de la UE, compuesto por los gobiernos nacionales de la UE, adoptó su posición en diciembre de 2022. El Parlamento Europeo tiene como objetivo tener una votación final para formar su posición oficial sobre 14 de junio, después del cual las dos instituciones, junto con la Comisión Europea, deberán acordar un texto común para el Reglamento.